###Cost function

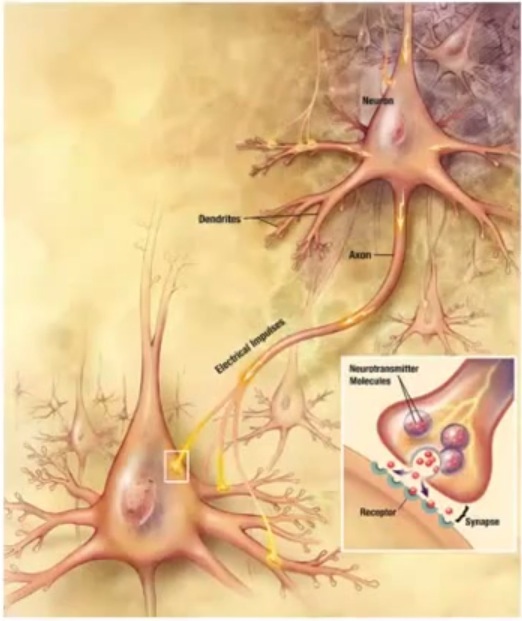

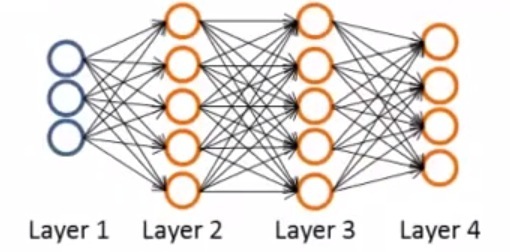

假定我们有下面这个神经网络

样本为: 并且用L表示该神经网络的层数,用$s_l$表示第l层有几个节点(不含bias),用K表示输出层的节点个数。

针对K的个数不同,可以分为Binary分类和Multi-class 分类。

而神经网络的cost function值之前在logistic regression的泛化。 先回顾一下logistic regression cost function:

神经网络的cost function则是把它扩展,输出层的K也要考虑到,因为有多个输出啊,而且每一层也有多个节点,都是前一层的输出。

注意,正则项依然是不要计算到bias项,i从1开始

###Gradient computation 针对文章开头的神经网络,假定我们只有一个样本(x, y), 于是我们FP的过程如下:

,增加

,增加

而该网络的BP过程如下: 损失函数是由预期值和激活值的实际误差产生。 = ‘error’ of node j in layer l 于是: 对其他几层,则采用后一层的损失函数来继续计算

技巧:这是因为g(x)是sigmod函数才有的特性